주요소식 다음과 같은 유용한 정보들을 만나보실 수 있습니다. RSC Explorer - React Server Components 시각화 도구 Dan Abramov가 React Server Components(RSC) 프로토콜을 시각화하는 도구를 공개했다. 브라우저에서 RSC 스트림을 단계별로 재생하고 분해할 수 있으며, 서버·클라이언트·flight·...

기술 블로그 모음

국내 IT 기업들의 기술 블로그 글을 한 곳에서 모아보세요

"어떻게 하면 더 많은 팀이 우리 시스템을 잘 사용하게 할 수 있을까?" TDS가 이 질문에 답하기 위해 고민했던 과정을 공유합니다.

…

게스트 기사 작성자: Urs Peter, 수석 소프트웨어 엔지니어 겸 JetBrains 인증 Kotlin 트레이너. 더 체계적인 방법으로 Kotlin 역량을 높이고 싶은 독자를 위해 Urs는 Xebia Academy에서 Kotlin 역량 강화 프로그램도 운영합니다. 이 글은 Java 기반 환경에서 Kotlin을 성공적으로 도입하기 위한 완벽 가이드라는...

배민선물하기팀은 선물하는 이의 마음과 받는 이의 즐거움을 잇는 ‘배민선물하기’ 서비스를 담당하며, 배달의민족(이하 배민) 앱 내 상품권 발행부터 외부 채널과의 유통망 연동을 관리하고 있습니다. 이번에 소개할 프로젝트는 카카오톡에서 선물 받은 브랜드 교환권을 배민 앱에 직접 등록해 결제에 사용할 수 있도록 구현한 ‘외부 교환권 연동...

디자인 컴포넌트 라이브러리 빌드 및 구조 개선기

들어가며 배달의민족 주문접수 채널은 파트너의 주문 관리를 돕기 위해 매일 수백만 건의 주문을 실시간으로 처리하며, 다양한 디바이스를 지원하고 있습니다. 점차 다양해지는 디바이스 생태계에 대응하고자, 신규 제품에 Flutter + Clean Architecture를 선택했고, 나아가 비즈니스 요구사항에 더 빠르게 대응하기 위해 웹뷰 기반 컨테이너 앱(A...

네이버 사내 기술 교류 행사인 NAVER ENGINEERING DAY 2025(10월)에서 발표되었던 세션을 공개합니다. 발표 내용 네이버파이낸셜 디자인시스템과 AI를 이용하여 마크업 자동화 작업에 대한 소소한 경험을 공유합니다. 발표 대상 AI를 이용한 마크업 등 디자인 작업관련 관심 있으신 모든 분들 목차 오늘 이야기의 키워드 知彼知己 네이버파이낸...

우아한테크코스(이하 우테코)는 우아한형제들이 운영하는 10개월 과정 개발자 교육 프로그램입니다. 개발자 교육에서 기술만 배우면 될까요? 우테코는 소프트 스킬도 중요하게 생각하고 있습니다. 그래서 웹 백엔드, 웹 프론트엔드, 모바일 안드로이드와 같은 기술적인 과정뿐만 아니라 말하기와 글쓰기 교육을 같이 진행하고 있습니다. 커리큘럼은 5단계의 레벨로 구성...

SDK를 개발하며 마주한 다양한 상황과 기술적 어려움, 그리고 이를 해결하기 위해 우리가 설정한 핵심 가치와 달성해온 과정을 공유합니다.

네이버 사내 기술 교류 행사인 NAVER ENGINEERING DAY 2025(10월)에서 발표되었던 세션을 공개합니다. 발표 내용 Large Screen을 대응해야 하는 이유와 품질 가이드라인을 소개합니다. 글로벌웹툰이 View와 Compose 환경에서 Large Screen 최적화를 적용한 내용을 일부 공유합니다. 발표 대상 Large Screen...

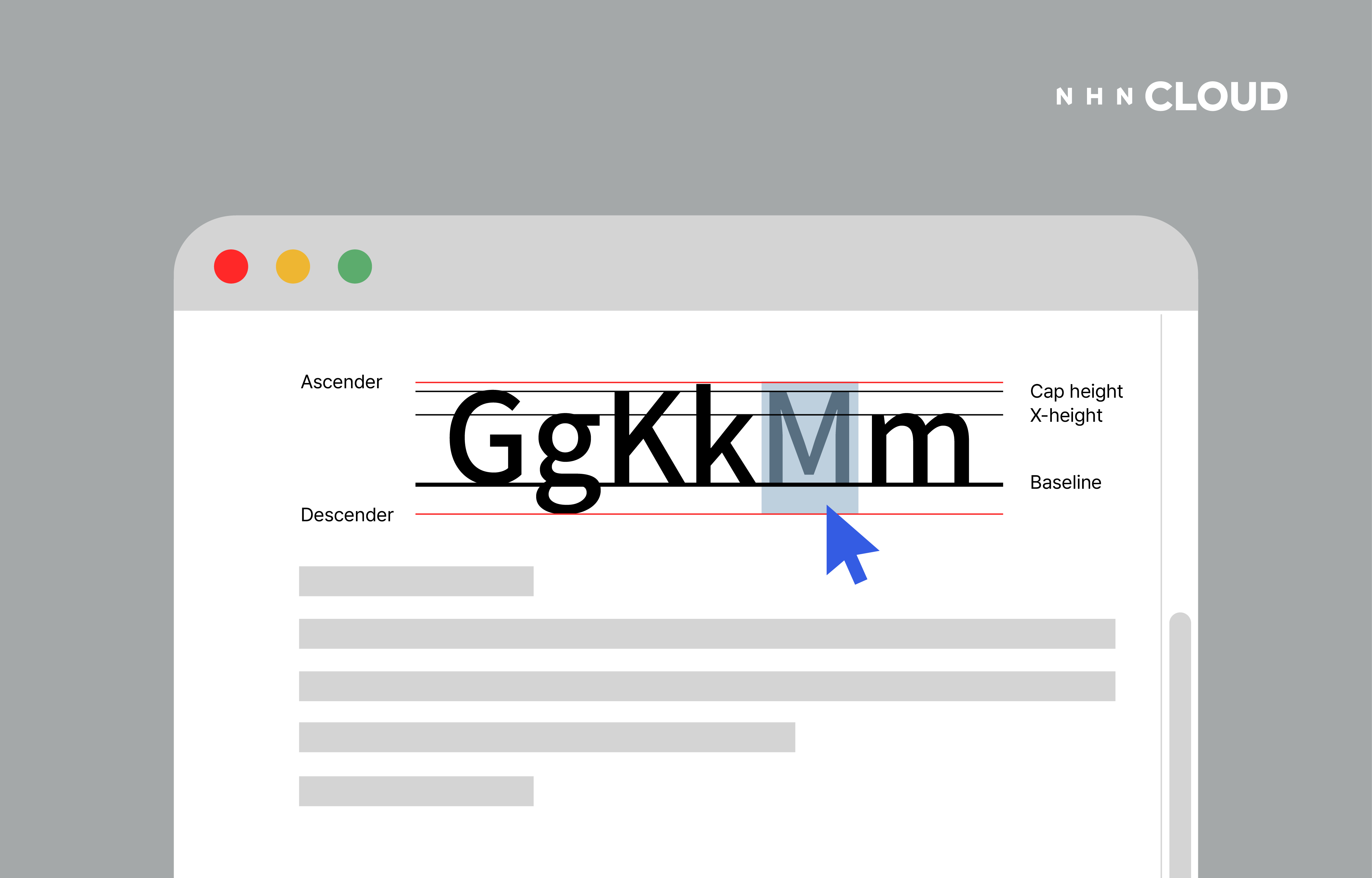

[](https://www.nhncloud.com/kr) 혹시 어떤 요소에 넣은 텍스트를 예쁘게...

안녕하세요! 발레를 좋아하는 올리브영의 프론트엔드 개발자 개발레리나🩰 입니다. 마이크로프론트엔드(Micro Frontend Architecture,이하 MFE…

주요소식 다음과 같은 유용한 정보들을 만나보실 수 있습니다. 1. React Conf 2025 - React의 대규모 업데이트 React 19.2에서 컴포넌트와 useEffectEvent() 훅을 도입하고 React Compiler 1.0을 정식 출시하여 자동 최적화를 제공합니다. 특히 Meta Quest 스토어 앱에서 로드 시간 12% 개선과 2배 ...

📖 목차 개요 모듈 페더레이션(Module Federation - MF) 넌 뭐니? MF의 특징은 뭐가 있을까? MF의 구현 방법은? MF…

안녕하세요! 올리브영의 iOS Junior Engineer Ted입니다. 저는 오늘, 올리브영 iOS…

…

원티드 엔지니어분들은 원티드 플랫폼을 개발하고 운영하며, 더 나은 사용자 경험을 제공하기 위해 끊임없이 노력하고 있습니다.그 노력의 일환으로, 저희는 ‘SEO 주도 개발’을 실천하고 있습니다.‘SEO 주도 개발’이란, Google Search Console (이하 GSC)과 도구를 통해 SEO 관련 지표를 주기적으로 관찰하고, 이를 개선하는 것을 개발...

들어가며 식당에 있다 보면 “배달의민족 주문~!” 알림을 한 번쯤 들어보셨을 거예요. 이 알림은 주문이 들어올 때 사장님이 빠르게 확인하고 처리할 수 있도록 도와주는 주문 접수 프로그램에서 발생합니다. 이 프로그램을 만드는 팀이 바로 주문접수채널팀으로, Windows·macOS PC, 모바일 앱(Android, iOS), Android POS 등 다양...

지난 글 "우아한 디버깅 툴 1부: 웹뷰/웹페이지 원격으로 디버깅하기"에서는 이슈 정보를 쉽게 기록하고 공유하는 방법에 대해 다뤘습니다. 하지만 QA를 더 원활하게 진행하기 위해서는 아직 개선해야 할 부분이 많았습니다. 이번 글에서는 QA 업무 생산성 향상을 위해 추가한 기능들을 소개합니다. 들어가기 전 복습하기 기록방 : 원격 디바이스에서 기록한 데...

버그 재현, 생각보다 쉽지 않습니다 버그가 발견되었을 때 프론트엔드 개발자가 가장 많이 하는 말이 있습니다. “제 기기에선 잘 되는데요…?” 이슈가 발생하면 우리는 가장 먼저 상황을 똑같이 재현해보려 합니다. 하지만 재현이 항상 되는 건 아닙니다. 간헐적으로만 나타나거나, 특정 계정·환경에서만 발생하는 경우도 많죠. 예시 상황으로 알아보기 예를 들어,...

BFF의 탄생 배경과 핀테크그룹 프론트엔드에서 BFF를 어떻게 활용하는지 소개합니다

![[디자인 시스템 어떻게 만들었어요?(1)] 아이콘 라이브러리 만들기](https://cdn-images-1.medium.com/max/1024/1*kCf05hhyLPa7iBp2vBTJAA.png)

YDS(Yogiyo Design System)는 요기요에서 운영하는 디자인 시스템입니다. 요기요에서는 YDS를 구축하여 개발자와 디자이너의 생산성을 향상시키고, 사용자에게는 일관된 경험을 제공하고 있습니다.요기요 FE팀은 YDS version 2를 재구축하는 과정에서 얻은 인사이트를 세 편의 글로 나누어 공유하고자 합니다.아이콘 라이브러리 만들기sty...

왜 이 일을 시작했나요?음식 배달 서비스의 점주님용 앱을 운영하는 동안 꾸준히 같은 피드백이 들어왔습니다."메뉴 등록이 너무 어려워요. 더 쉽게 해주세요."문제는 옵션과 사이즈, ...

주요소식 다음과 같은 유용한 정보들을 만나보실 수 있습니다. 1. React 생태계 혁신 정체 논란 React가 프런트엔드 개발의 사실상 표준이 되면서 오히려 기술 혁신이 정체되고 있다는 흥미로운 관점이 제기되었습니다. 채용 시장에서 React 경험을 우선시하는 경향과 기업들의 안전한 선택 성향이 다른 프레임워크 탐색을 저해하고 있다는 분석입니다. 프...

"삐빅, 삐빅." 1분 1초가 급박하게 돌아가는 물류센터. 이곳에서 현장 작업자의 손에 들린 PDA(산업용 단말기)의 작은 화면은 전쟁터의 레이더와 같습니다. 하지만 이 레이더가 낡고 해상도가 낮다면? 브라우저 툴바가 화면의 1…

안녕하세요 Local Business 프론트플랫폼팀의 Joon이에요.Continue reading on 당근 테크 블로그 »

주요소식 다음과 같은 유용한 정보들을 만나보실 수 있습니다. Augmented vs Vibe Coding: Kent Beck은 BPlusTree3 라이브러리를 통해, Vibe Coding보다 코드 품질과 복잡성을 중시하는 Augmented Coding의 중요성을 설명했습니다. Rust, Python, C 등 다양한 언어로도 구현했습니다. Code w/...

안녕하세요! 올리브영 프론트엔드 개발자 쩡다입니다. "하나의 콘텐츠를 만드는 데 정말 7일이나 걸려야 할까요?" 이 질문에서 시작된 올리브영의 콘텐츠 제작 프로젝트를 소개합니다. 직접 구축한 블록 기반 CMS로 제작 시간을 7일에서 2…

![[FE Ground] 'AI x Front-End: 코딩의 미래를 묻다' 밋업이 열립니다.](/content/images/2025/08/88a2b32c-0ec6-4ba5-9ea1-e1f8362e0ea7_1812x1194.png)

안녕하세요! 네이버 프런트엔드 개발자 모임 H26y입니다. 매달 FE News를 통해 찾아뵈었는데요, 8월 29일(금), “[FE Ground] AI × Front-End: 코딩의 미래를 묻다.”라는 주제로 첫 공개 개발자 밋업을 진행하게 되어 안내드립니다. 진행일시 일시: 8월 29(금), 19시 ~ 21시 건물 보안 지침 상 사전 입장이 불가하며,...