재고 정산 처리에 Kafka Streams window를 도입하며 겪은 이야기

기술 블로그 모음

국내 IT 기업들의 기술 블로그 글을 한 곳에서 모아보세요

웹 애플리케이션을 개발하다 보면 하나의 HTTP 요청 내에서 동일한 외부 API를 여러 번 호출하거나 동일한 연산을 반복하는 경우가 종종 발생합니다. 이러한 중복 호출은 응답 시간을 증가시키고 불필요한 네트워크 오버헤드를 유발합니다. 이 글에서는 이러한 문제를 해결하기 위해 개발한 @RequestCache라는 커스텀 애너테이션의 개발 과정과 그 과정에...

전자계약서 시스템에서는 다양한 업무 목적에 따라 여러 형태의 대용량 엑셀 파일을 생성할 수 있습니다. 예를 들어 생산성 지표 엑셀, 근무 관리 엑셀, 행정 처분 추정 업주 엑셀, 계약현황 엑셀 등 각기 다른 조건과 데이터로 구성된 엑셀을 이메일로 받아볼 수 있는 기능인데요. 데이터 조건에 따라 엑셀 생성 시간이 오래 걸려, 화면에서 결과를 기다리지 않...

네이버 사내 기술 교류 행사인 NAVER ENGINEERING DAY 2025(10월)에서 발표되었던 세션을 공개합니다. 발표 내용 Consumer Group Protocol v2를 소개합니다. 발표 대상 조직에서 Kafka를 사용하거나 관심 있는 분들 Consumer Group Protocol 에 대해 관심 있는 분들 목차 Consumer Group...

네이버 사내 기술 교류 행사인 NAVER ENGINEERING DAY 2025(10월)에서 발표되었던 세션을 공개합니다. 발표 내용 API 호출식 웜업의 부작용을 개선한 라이브러리 웜업을 소개합니다. 발표 대상 JVM JIT Compiler의 웜업 방식 기본을 알고 있는 분 또는 관심있는 분 JVM 기반 웹 어플리케이션의 웜업에 관심있는 분 목차 JV...

'백엔드 개발자를 꿈꾸는 학생개발자'에게 후속편이 7년만에 돌아옵니다! NAVER D2 블로그를 보고 계신 분들이라면 한번쯤은 '백엔드 개발자를 꿈꾸는 학생개발자에게' 라는 글을 본적이 있으실텐데요, 무려 작성된 지 7년이 지났지만 지금도 꾸준히 TOP 5에 드는 D2 블로그의 대표 글 중 하나입니다. 이 글을 작성해주셨던 NAVER 정상혁 님께서 그...

들어가며 빠르게 변화하는 이커머스 환경에서, SDUI(Server-Driven UI)는 선택이 아닌 필수가 되어가고 있습니다. SDUI…

데브시스터즈에서 개최한 세 번째 엔지니어링 데이 - 게임 서버를 소개합니다.

개발자들에게 익숙해진 불편함을 해결하기 위한 사내의 Swagger MCP 서버를 구축한 이야기를 들려드립니다.

20년간 유지되어 온 PG의 레거시 결제창 시스템을, 변화에 유연하게 진화할 수 있는 새로운 결제 시스템으로 재탄생시킨 여정을 공유합니다.

오늘은 범용 M 인스턴스 패밀리에 최근에 추가된 Amazon Elastic Compute Cloud(Amazon EC2) M8a 인스턴스의 출시를 발표합니다. 이 인스턴스는 최대 주파수가 4.5GHz인 5세대 AMD EPYC(코드명 Turin) 프로세서로 구동됩니다. 고객은 M7a 인스턴스에 비해 최대 30% 더 높은 성능과 최대 19% 개선된 가격 ...

Amazon Elastic Compute Cloud(Amazon EC2) 메모리 최적화 R8i 및 R8i-flex 인스턴스와 범용 M8i 및 M8i-flex 인스턴스를 출시한 후, AWS에서만 제공되는 맞춤형 Intel Xeon 6 프로세서 기반의 컴퓨팅 최적화 C8i 및 C8i-flex 인스턴스의 정식 출시를 발표하게 되어 기쁩니다. 이 인스턴스는 ...

오늘은 Amazon Elastic Container Service(Amazon ECS)의 새로운 컴퓨팅 옵션인 Amazon ECS Managed Instances를 발표합니다. 이 옵션을 사용하면 개발자들이 Amazon Elastic Compute Cloud(Amazon EC2)의 모든 기능을 사용하는 동시에 인프라 관리 책임을 Amazon Web S...

안녕하세요. 당근페이 오프라인 결제팀에서 백엔드 엔지니어로 일하고 있는 윈터(Winter.you)예요.저희 팀은 당근머니가 온라인을 넘어 오프라인에서도 자연스럽게 쓰일 수 있도록 만드는 일을 하고 있어요.이번 글에서는 저희가 7주 만에 준비했던 QR 기반 현장결제에 대해 소개하려고 해요. 여기서 말하는 현장결제란 오프라인 매장에서 당근머니나 포인트로 ...

토스페이먼츠 엔지니어들이 지난 몇 년 간 쏟아부은 치열한 고민과 노력을 기록한 시리즈를 소개합니다.

올리브영이 데이터의 품질을 높이기 위한 여정 "고객이 100원 상품을 클릭했는데 결제하고 보니 10,00…

안녕하세요. 저는 당근 피드실 피드 인프라팀에서 Software Engineer로 일하고 있는 Lebron이라고 해요.당근 피드는 당근 앱에 있는 다양한 콘텐츠를 모아서 하나의 리스트로 보여줘요. 사용자는 피드를 통해 중고거래, 구인 공고, 중고차, 부동산 등 자신에게 맞춤화된 정보를 한눈에 확인할 수 있어요. 이 피드시스템은 당근의 핵심 기능으로, ...

CDC를 Iceberg에 어떻게 안전하게 적재할 수 있는지에 초점을 맞춰, 우리가 마주했던 문제와 원칙들을 공유합니다.

오늘, 새로운 8세대 메모리 최적화 Amazon Elastic Compute Cloud(Amazon EC2) R8i 및 R8i-flex 인스턴스의 정식 출시를 발표합니다. 이 인스턴스는 AWS에서만 제공하는 맞춤형 Intel Xeon 6 프로세서로 구동됩니다. 동급 Intel 프로세서 중 가장 뛰어난 성능과 가장 빠른 메모리 대역폭을 클라우드에 제공합...

웹 프레임워크는 웹 서비스, 리소스, API를 포함한 웹 애플리케이션 개발을 지원하도록 설계된 소프트웨어 도구입니다. 일반적으로 모범 사례, 도구, 테스트 리소스, 라이브러리를 갖춘 완전한 패키지 형태로 제공되어 앱을 더 쉽게 개발할 수 있도록 돕습니다. 프레임워크는 명확한 구조를 제공하며, 일반적으로 널리 사용되는 MVC(모델-뷰-컨트롤러) 설계 패...

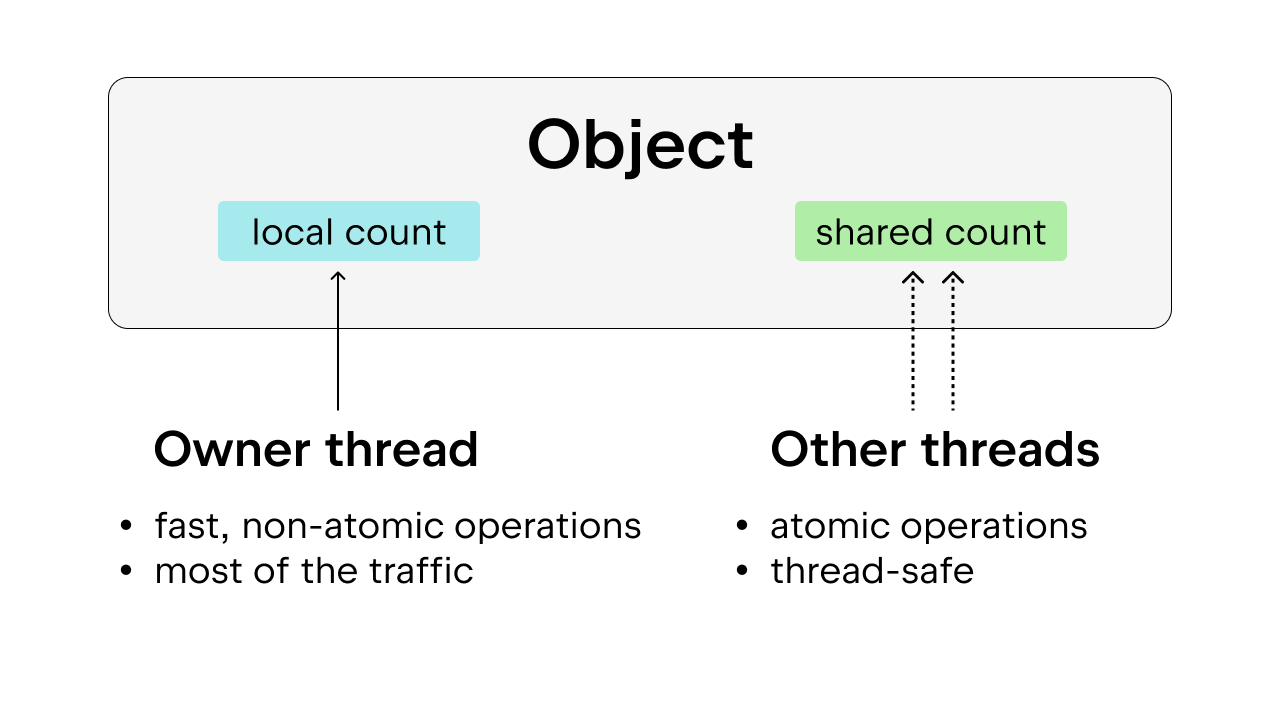

Python의 전역 인터프리터 잠금(GIL)이란? ‘전역 인터프리터 잠금'(또는 GIL)은 Python 커뮤니티에서는 익숙한 용어로, 잘 알려진 Python 작동 방식입니다. 그렇다면 GIL은 정확히 무엇일까요? 다른 프로그래밍 언어(예: Rust)를 사용해 본 적이 있다면 뮤텍스가 무엇인지 아실 겁니다. 뮤텍스는 ‘mutual ...

토스증권의 실시간 데이터 파이프라인을 대규모로 구성하고 운영해 온 경험을 소개합니다.

안녕하세요. 네이버페이에서 카드 BE 담당하고 있는 허수진입니다. 🙂저희 팀에서는 데이터베이스의 실제 저장 형태와 무관하게 애플리케이션에서 타입 안정성을 확보하면서 원하는 형식으로 데이터를 다루기 위해서 Spring Data JDBC에서 커스텀 컨버터를 사용하고 있습니다.e.g.DB에는 문자열로 저장되어 있지만 애플리케이션에서는 LocalDate로 다...

저희 팀에서는 Apache Spark를 기반으로 배치 및 실시간 처리를 수행하는 AI 데이터 파이프라인을 구축하고 있습니다. 그 과정에서 Spark의 마이크로 배치 아키텍처보다 더 효율적이고 생산적으로 실시간 데이터를 수집하고 집계하는 방법을 고민해왔습니다. 이 글에서는 Apache Flink와 Apache Paimon을 도입하여 빠르고 안정적인 데이...

안녕하세요! 동네생활팀 프론트엔드 엔지니어 인턴 링커(Linker)예요. 저희 팀은 동네 정보와 이야기를 자유롭게 나누는 커뮤니티, 동네생활을 만들고 있어요.동네생활은 모바일 기기 성능이 좋지 않거나 웹뷰 로딩이 느린 환경에서도 사용자에게 원활한 경험을 제공하기 위해 Streaming SSR*을 도입했어요. 이런 구조에서 디버깅을 수월하게 하기 위해 ...

네이버 사내 기술 교류 행사인 NAVER ENGINEERING DAY 2025(5월)에서 발표되었던 세션을 공개합니다. 발표 내용 이 세션에서는 BERT기반 모델인 SPLADE모델의 대규모 실시간 서비스를 위한 최적화 방법에 대해서 이야기 합니다. 세상에서 가장 빠른 BertTokenizer 구현체인 FlashTokenizer 의 개발 배경과 성능에 ...

NGINX Socket Reverse Proxy 구성 현대의 웹 애플리케이션은 단순한 요청-응답 패턴을 넘어, 실시간 데이터 통신을 요구하는 다양한 기능들을 필요로 합니다. 대표적으로 채팅 서비스, 실시간 알림, 스트리밍 등이 그 예입니다. 이러한 실시간 통신을 가능하게 하는 기술 중 하나가 Socket입니다. 본 문서에서는 Socket의 개념부터 시...

오늘 AWS AppSync Events가 이제 채널 네임스페이스에 대한 데이터 소스 통합을 지원하게 되었다는 소식을 알려드립니다. 이로써 개발자 여러분은 앞으로 더 정교한 실시간 애플리케이션을 제작할 수 있게 됩니다. 이 새 기능을 통해 AWS Lambda 함수, Amazon DynamoDB 테이블, Amazon Aurora 데이터베이스 및 기타 데이...

오늘은 BESPIN GLOBAL AIX실 전희연님이 작성해주신 'Springboot 구동시 AWS Secret을 조회하여 Datasource 생성'에 대해 소개해드리도록 하겠습니다. The post Springboot 구동시 AWS Secret을 조회하여 Datasource 생성 appeared first on BESPIN Tech Blog.

오늘은 AWS WAF의 AWS Amplify Hosting 통합 정식 출시 소식을 알려드립니다. 웹 애플리케이션 소유자는 다양한 위협으로부터 애플리케이션을 보호하기 위해 끊임없이 노력 중입니다. 이전에는 Amplify Hosting으로 호스팅되는 애플리케이션에 강력한 보안 태세를 구현하려면 AWS WAF 보호가 지원되는 Amazon CloudFront...