안녕하세요! 뱅크샐러드의 Server Engineer 조성민입니다. 이번 글에서는 제 팀인 금융쇼핑 PA…

기술 블로그 모음

국내 IT 기업들의 기술 블로그 글을 한 곳에서 모아보세요

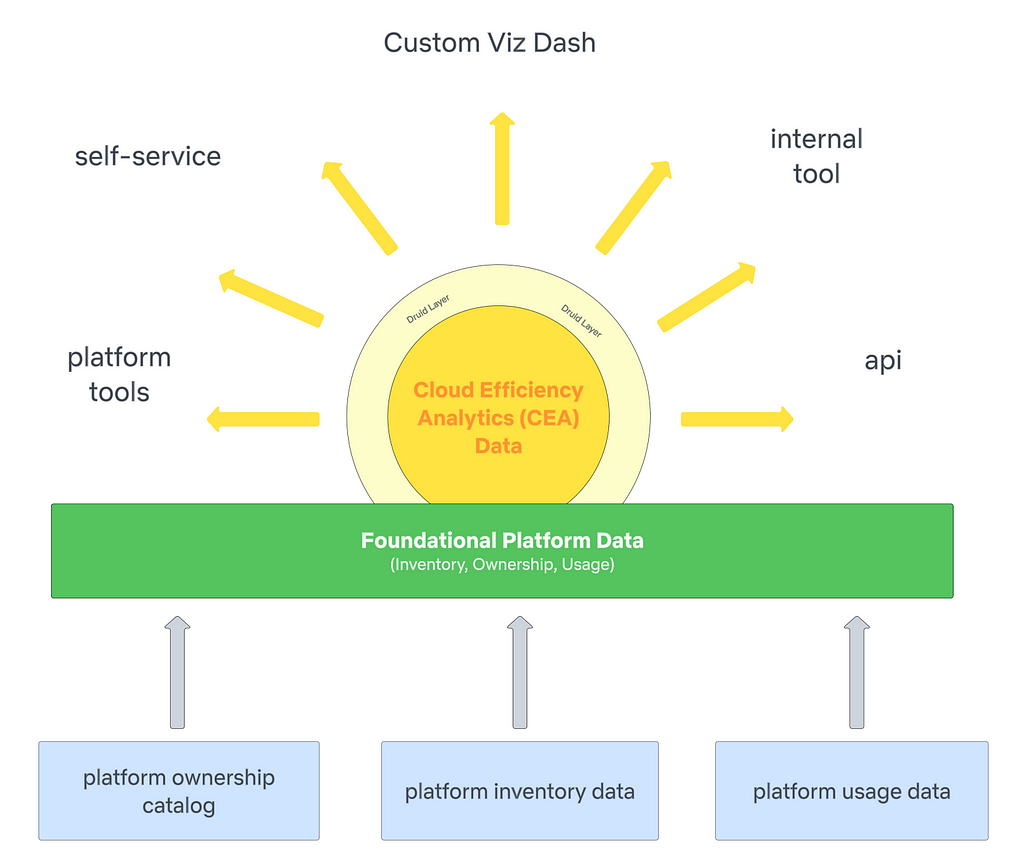

By J Han, Pallavi PhadnisContextAt Netflix, we use Amazon Web Services (AWS) for our cloud infrastructure needs, such as compute, storage, and networking to build and run the streaming platform tha...

Part 1: Understanding The ChallengesBy: Varun KhaitanWith special thanks to my stunning colleagues: Mallika Rao, Esmir Mesic, Hugo MarquesIntroductionAt Netflix, we manage over a thousand global co...

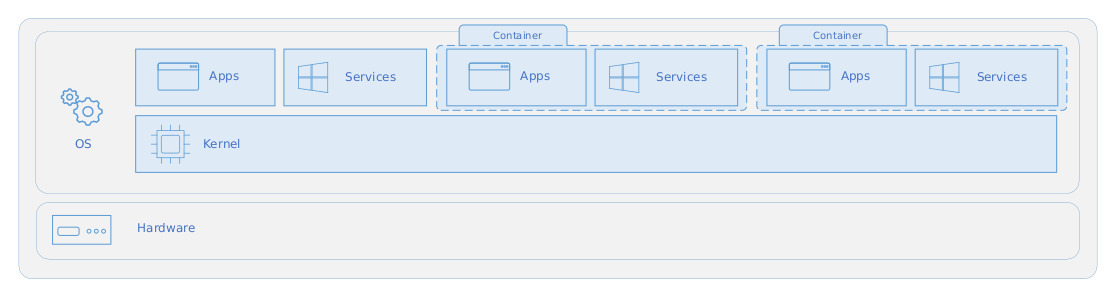

안녕하세요 Dev Platform & Corporate IT팀 팀 박진규입니다.이번 포스팅에서는 Windows Container에 대한 내용을 공유드리려 합니다. 제가 담당하는 서비스들 중에서는 Windows OS에 종속적인 서비스들이 존재하는데,(ex. net framework)어...

![[네이버웍스] 경영지원 활용팁 웍스 경영지원 데모 계정에 초대합니다.](https://blogthumb.pstatic.net/MjAyNDEyMDlfMjI0/MDAxNzMzNzA2OTEwNjc5.jyAQNCmKVzb1N07O1ZMptJGVnSd0zN-HDzBVBOWRHtIg.qVGQh3Saso3_f8baDpwK_IGeuy-0WWQNCrWSBzjNbWEg.PNG/w_demo2.png?type=s3)

안녕하세요, 협업과 소통을 위한 필수 기능으로 글로벌 53만 기업의 든든한 협업툴 역할을 해온 네이버웍스(NAVER WORKS)입니다! “웍스 경영지원 도입을 검토하고 있는데, 상품 신청 전에 둘러볼 수 있는 방법이 없을까요?” “웍스 경영지원 상품을 가입했고 30일 무료 체험 중인데, 관리자와 사용자 역할을 왔다 갔다 하며 간편하게 테스트할 수 있는...

![[NEWS] 네이버클라우드, '2024년 가족친화인증기업'으로 선정](https://blogthumb.pstatic.net/MjAyNDEyMDlfMTE3/MDAxNzMzNzM1NjIyNjE5.QtXmi9Rvh-LXaySJWF7uId_qDIIPrKFERLzu2k_oB70g.0klV69JlbH3uU9RqW1_6jU-3-eU1BhpEd9MRJA_0xUEg.PNG/네이버클라우드_블로그_썸네일.001.png?type=s3)

안녕하세요, 누구나 쉽게 시작하는 클라우드 네이버클라우드 ncloud.com 입니다. 오늘은 기쁜 소식을 전해 드리러 왔습니다! 네이버클라우드가 '2024년 가족친화인증기업’으로 선정되었습니다! *가족친화인증이란? 가족친화제도를 모범적으로 운영하는 기업 및 공공기관에 대하여 심사를 통해 여성가족부가 인증을 부여하는 제도 네이버클라우드는 일과 가정생활을...

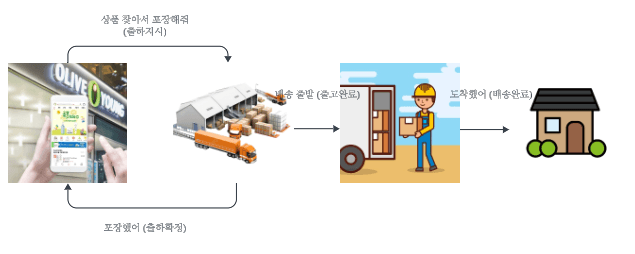

안녕하세요 올리브영의 POS서버를 맡고있는 개발자 Q평E평 입니다. 여러분은 운영 중인 시스템 배포를 어떻게 하고 있으신가요? 최근엔 다양한 CI/CD…

Spring Kafka 활용한 오프셋 이동 및 메시지 재처리 방법

안녕하세요, 플레이스데이터플랫폼 나호철입니다.이번 글에서는 YARN 클러스터에 배포된 Trino 클러스터의 리소스 구성 및 리소스 관련 설정을 순차적으로 최적화하여 장비 증설 없이 쿼리를 처리하는데 사용되는 클러스터 가용 메모리를 약 40% 가량 증가시킨 과정에 대해 간략히 공유하려고 합니다.저희 플레이스데이터플랫폼(aka. PDP) 팀은 플레이스의 ...

LLM 애플리케이션 테스트의 어려움 GPT-4와 같은 대규모 언어 모델(large language model, 이하 LLM)이 대중화되고 이를 활용한 LLM 애플리케이션 역시 다양...

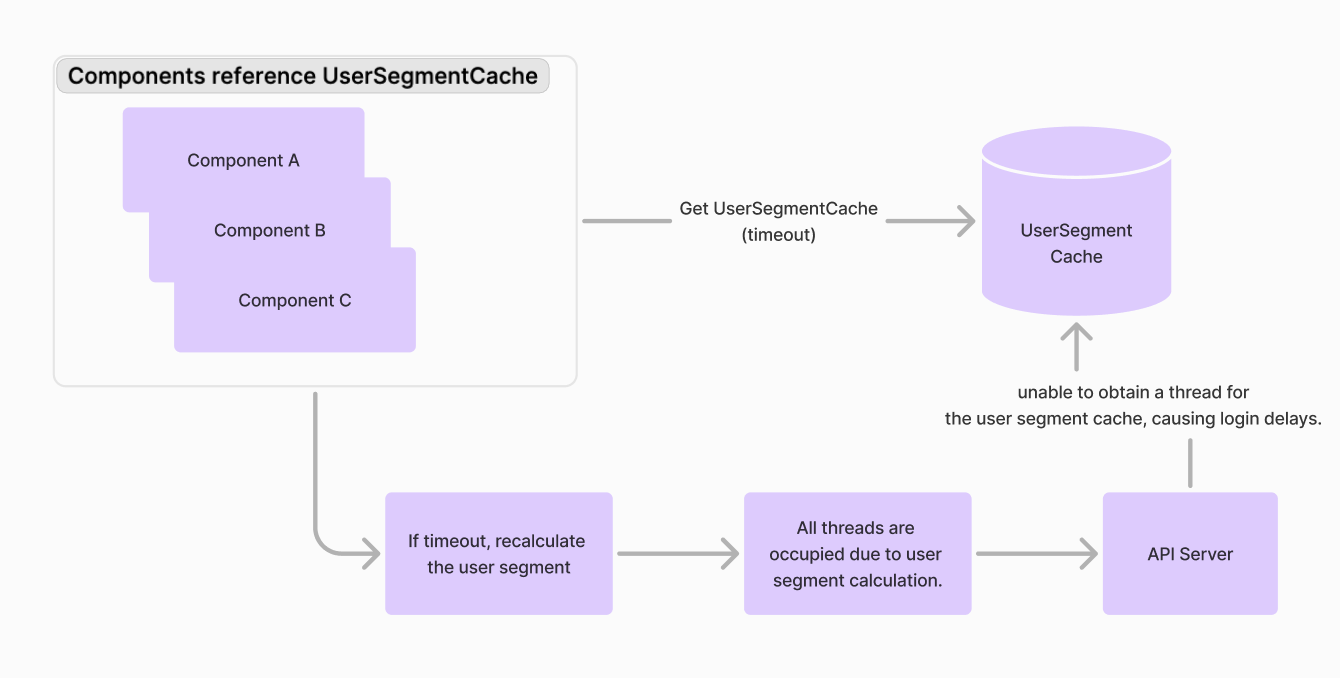

안녕하세요, SRE팀의 Ken.K입니다. Hyperconnect는 2024년에 접어들면서, 일부 국가의 사용자들에게 체감될 수 있는 장애부터 로그인 실패 같은 심각한 장애까지 여러 번의 대형 사고를 겪었습니다. 사실, 마이크로서비스 단위의 문제는 서비스 운영 중에 자주 발생하는 것이며, 각 프로덕트 팀의 온콜 대응 숙련도가 이미 높기 때문에 잘 대처하...

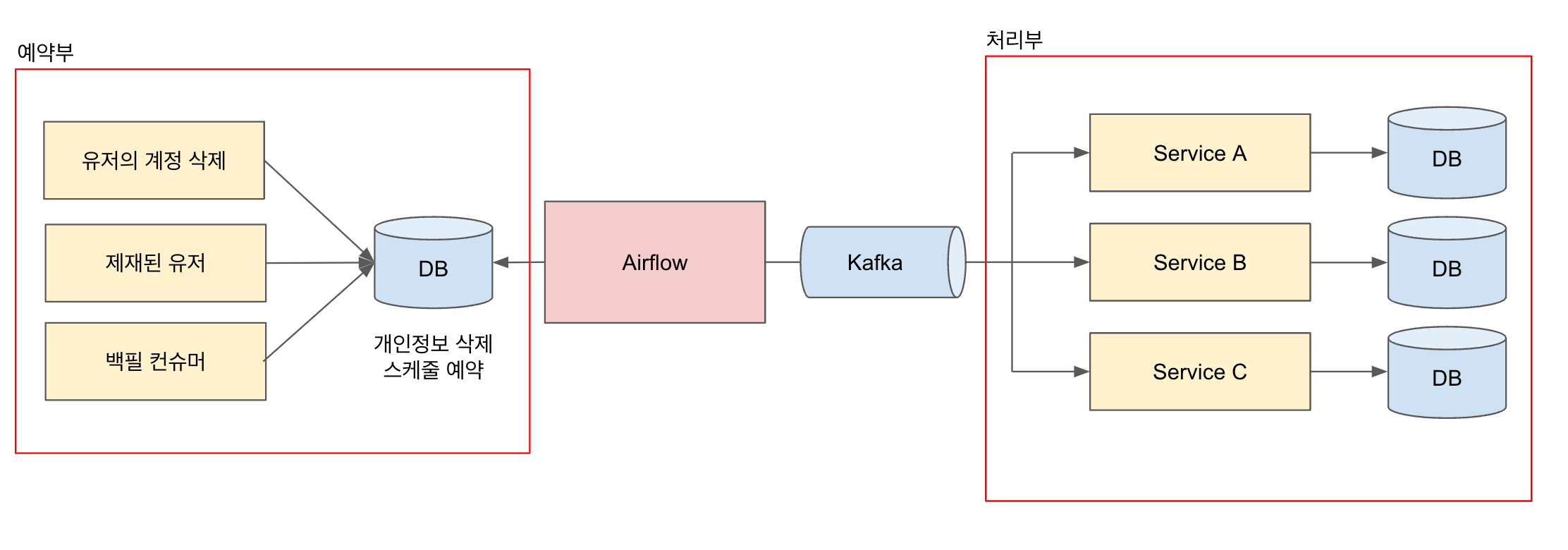

안녕하세요. Azar API Dev Team의 Ledger 입니다. 아자르는 유럽, 아시아, 중동 등 다양한 지역에서 사랑받고 있는 글로벌 서비스 입니다. 글로벌 서비스를 운영하기 위해서는 고려해야 할 것이 많은데 그 중 유저 데이터의 라이프 사이클에 대해 다뤄보려 합니다. 유저의 프라이버시를 위해 유저가 탈퇴하거나 오랜 시간 접속하지 않는다면 유저의...

안녕하세요. 카탈로그서비스개발팀에서 백엔드 개발을 담당하는 빅토르입니다. Debezium MSK Connect를 운영하며 안정성을 고민했던 경험과 Connector 중단 시 해결 방법에 대해 공유해보겠습니다. Debezium MSK Connect…

…

29CM QA팀도 테스트 자동화를 사용하시는 타 QA분들처럼 CI/CD(저희는 Jenkins를 사용합니다) 툴을 사용해서 테스트 자동화를 수행하고 있습니다.테스트 자동화를 위해 29CM앱의 전반적인 주요 기능을 검증 할 수 있도록 E2E 시나리오 28개를 (33개였으나 수행불가 시나리오제외)선정해놓고 APP 배포 전에 그것을 모두 수행하여 검증이 진행...

안녕하세요. Cloud DBS 팀에서 사내 클라우드인 Verda의 데이터베이스와 OpenSearch 서비스 개발을 맡고 있는 강인배, 문현균입니다. 이번 글에서는 저희 팀에서 쿠버...

WATCHA에서 서로 다른 클라우드 저장소 간의 데이터 마이그레이션 시스템을 구축한 경험을 소개합니다. #Kubernetes #ArgoWorkflows안녕하세요, WATCHA Server Platform 팀에서 플랫폼 엔지니어로 일하고 있는 루카입니다.WATCHA에서 모은 데이터를 효율적으로 분석하고 활용하기 위해 기존 데이터 마이그레이션 프로세스를 ...

들어가며 안녕하세요. LINE Plus에서 Global E-Commerce Platform 개발을 맡고 있는 장효택입니다. LINE Brand Catalog와 통합 커머스 검색 ...

안녕하세요, 뉴넥스 AI 검색팀의 신누리입니다. 현재 팀 내 유일한 검색 담당으로서, 뉴넥스의 패션 커머스 플랫폼들 -브랜디, 하이버, 서울스토어, 셀피- 전체 검색 프로덕트를 책임지고 있습니다. 구체적으로는 검색 데이터 파이프라인 구축 및 유지보수, 검색엔진 관리, 검색 API 개발, 검색 사전 관리 등 검색과 관련된 모든 부분을 매니징하고 있습니다...

안녕하세요. 쿠버네티스에서 파드를 분산 처리할 때 사용할 수 있는 토폴로지 분배 제약 조건(topology spread constraints) 활용 사례를 공유할 ContentsS...

안녕하세요. 올리브영 플랫폼엔지니어링팀 리더 무스타파🌙입니다. DASH 2024 Datadog에서는 매년 새롭게 런칭되는 서비스와 다양한 성공 사례와 경험을 공유하기 위해서 뉴욕에서 DASH라는 컨퍼런스를 개최합니다. 이번 DASH 202…

이 아티클에서는 클라우드 전환 단계별로 적절한 보안 전략을 수립하고, 보다 안전하고 효율적인 클라우드 환경을 구축할 수 있도록 가이드를 제공합니다.

안녕하세요. Data Platform Dev에서 쿠버네티스 클러스터를 운영하며 컴포넌트를 개발하는 이현규입니다. 제가 운영하는 쿠버네티스 클러스터는 약 800대 규모로 주로 사내 ...

서버리스 Airflow를 쿠버네티스 환경으로 전환하며 경험한 삽질들

안녕하세요 사람인 SRE팀 박형규입니다. 지난 포스팅과(사이트 신뢰성에 대한 지표는 어떻게 구성할까?) 다르게 이번엔, AWS EKS 환경을 좀 더 안정적이며 확장성 있게 운영하기 위해 고민하고 테스트 했던 내용에 대해 공유 드리고자 합니다. 사람인은 K8S 플랫폼으로 On-Premise가 주이고 최근 서비스는 AWS EKS를 사용하고 있습니다. 초기...

안녕하세요. FMS 엔지니어링팀의 렉스, 마르코입니다. 저희 팀은 쏘카 외 차량 관제를 위한 PoC(Proof of Concept)를 진행했으며, 그 일환으로 주행 이벤트 탐지 파이프라인을 구축했습니다. 이 과정에서 다양한 문제를 해결하며 파이프라인을 지속적으로 개선해왔습니다. 다음과 같은 분들이 읽으면 좋습니다. EDA(Event Driven Arc...

# 들어가며 [NHN Cloud](https://www.nhncloud.com/?utm_source=meetup&utm_medium=post&...

안녕하세요. 올리브영 QA Enginner 멜짱입니다. 올리브영은 인시던트를 어떻게 관리하고 있는가?…

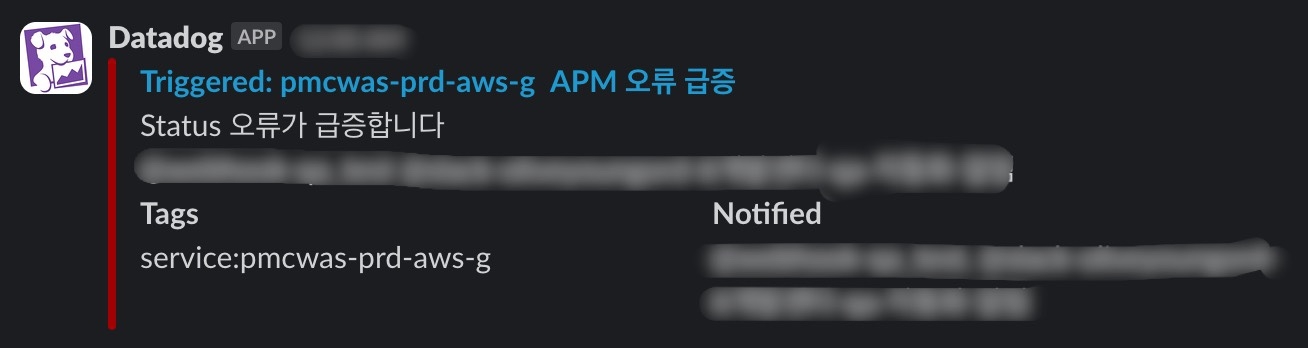

안녕하세요. 올리브영의 배포 문지기를 맡고 있는 QA 엔지니어 황소입니다. 이번 글에서는 Datadog을 올리브영 QA는 어떻게 활용하고 있는지에 대해서 공유합니다. 목차 QA가 Datadog을 활용하게 된 이유 올리브영 QA는 Datadog…

안녕하세요. FE개발팀 조성창 입니다. 사람인에선 서비스의 레거시 영역을 점진적으로 개선해 나가고 있습니다. 그동안 FE개발팀은 긱이나 멘토링 같은 버티컬 서비스의 FE개발을 진행해왔는데, 작년부터 주요서비스의 FE분리를 시작하면서 FE 영역의 아키텍쳐에 대한 고민을 했었습니다. 그 결과 Monorepo를 적용하기로 하였고 첫번째 서비스가 배포를 앞두...