이번 주에 AWS Summit 시즌이 시작됩니다! 클라우드 컴퓨팅 커뮤니티가 함께 교류하고 협업하고 배울 수 있는 이 무료 이벤트가 전 세계에서 펼쳐지고 있습니다. 온라인으로 참여하든 오프라인으로 참여하든 관계없이 이러한 모임은 AWS 지식을 넓힐 수 있는 귀중한 기회를 제공합니다. 저는 이번 주 프랑스에서 열리는 최대 규모의 클라우드 컨퍼런스인 파리...

기술 블로그 모음

국내 IT 기업들의 기술 블로그 글을 한 곳에서 모아보세요

NGINX One 이 플랫폼 운영팀에게 도움이 되는 방법 NGINX One 이란 팀이 반응형 관리 및 분산된 역할에서 사전 예방적 최적화 및 쉬운 협업으로 전환할 수 있도록 지원함으로써 최신 application delivery를 보다 효율적이고 안전하며 투명하고 확장 가능하게 만듭니다. 플랫폼 운영팀은 Kubernetes 클러스터와 클라우드 네이티브...

오늘은 BESPIN GLOBAL AI실 박성환님이 작성해주신 'AWS LAMBDA를 활용한 Account Helth Event 발생 정보 슬랙 전송(2)'에 대해 소개해드리도록 하겠습니다. The post AWS LAMBDA를 활용한 Account Helth Event 발생 정보 슬랙 전송(2) appeared first on BESPIN Tech B...

오늘은 BESPIN GLOBAL AI실 박성환님이 작성해주신 'AWS LAMBDA를 활용한 Account Helth Event 발생 정보 슬랙 전송(1)' 에 대해 소개해드리도록 하겠습니다. The post AWS LAMBDA를 활용한 Account Helth Event 발생 정보 슬랙 전송(1) appeared first on BESPIN Tech ...

NGINX Gateway Fabric 을 사용하여 다운타임 없이 애플리케이션을 업그레이드 하는 방법을 알려줍니다. 목차 1. 개요2. 필수 조건3. 롤링 배포 업그레이드 4. Blue-Green 배포5. Canary 릴리스 1. 개요 NGINX Gateway Fabric은 애플리케이션을 중단 없이 업그레이드할 수 있도록 지원합니다. 업그레이드 방법을 ...

NGINX Gateway Fabric Let’s Encrypt, cert-manager 통합 이 문서는 NGINX Gateway Fabric 을 Let’s Encrypt, cert-manager와 통합하여 인증서를 발급하고 관리하는 방법에 관해 설명합니다. 목차 1. NGINX Gateway Fabric, Let’s E...

‘데브시스터즈 엔지니어링 데이’를 소개합니다.

오늘, 운영 데이터를 조사하고 시각화하는 데 도움이 되는 AI 지원 기능을 제공하는 Amazon OpenSearch Service의 Amazon Q Developer 지원을 발표하게 되어 기쁩니다. Amazon Q Developer는 쿼리 언어, 시각화 도구 및 경보 기능에 대한 학습 기간을 단축함으로써 OpenSearch Service 환경을 개선합...

HAProxy Round Robin Load Balancing 웹 서비스의 가용성과 성능을 극대화하기 위해 로드 밸런싱을 필수적인 요소입니다. 다양한 로드 밸런싱 기법 중에서 Round-Robin 방식은 가장 간단하면서도 효과적인 방법으로 널리 사용되고 있습니다. HAProxy Round Robin load balancing은 강력한 툴로 자리 잡고 ...

AWS CodeBuild가 병렬 테스트 실행을 지원합니다. 이를 통해 테스트 스위트를 동시에 실행하여 빌드 시간을 크게 단축할 수 있습니다. 이 게시물을 위해 작성한 데모 프로젝트에서는 환경을 프로비저닝하는 시간을 포함하여 총 테스트 시간이 35분에서 6분으로 단축되었습니다. AWS Management Console에서 가져온 두 스크린샷이 그 차이를...

NGINX Canary 배포 를 NGINX Plus Ingress Controller에서 구현 NGINX Plus Ingress Controller를 활용한 NGINX Canary 배포 방식은 새로운 애플리케이션 버전을 안전하게 배포하는 전략입니다. 이 포스트에서는 NGINX의 기능을 통해 트래픽을 점진적으로 새로운 버전과 전환하여 안정성과 성능을 유...

AWS HealthOmics에 대한 전반적인 소개글입니다 :) The post AWS HealthOmics 소개 appeared first on NDS Cloud Tech Blog.

AWS Management Console에서 하나의 브라우저로 최대 5개의 계정에 동시 로그인할 수 있는 Multi-Session 기능을 소개합니다. The post AWS Management Console에서 Multi Session (다중 로그인) 기능 소개 appeared first on NDS Cloud Tech Blog.

NGINX Plus Sidecar 배포하고 Prometheus 연동하기 이 포스트에서는 쿠버네티스 환경에서 NGINX Plus Sidecar 를 배포하고 해당 메트릭을 Prometheus와 연동하는 방법을 알아봅니다. NGINX Plus는 고급 로드 밸런싱 기능과 모니터링 기능을 제공하여 애플리케이션의 성능을 극대화할 수 있습니다. NGINX Plus...

오늘부터 AWS 리전 및 AWS 가용 영역(AZ) 관련 지리적 위치 정보가 좀 더 세분화된 형태로 제공됩니다. 이러한 상세한 정보를 확보하면 규제, 규정 준수 및 운영 요구 사항과 일치하는 리전과 AZ를 선택할 때 유용합니다. AWS에서는 AWS 글로벌 인프라를 고객의 비즈니스 요구 사항에 맞춰 계속 확장하고 있으며, 현재 36개 리전에서 114개 A...

NGINX Plus Ingress Controller + Prometheus+ Grafana 통합 가이드 현대적인 애플리케이션 환경에서는 가용성과 성능을 보장하기 위해 다양한 모니터링 솔루션이 필요합니다. 특히, Kubernetes 환경에서 Ingress Controller의 상태를 효과적으로 모니터링하는 것은 서비스 운영의 핵심 요소 중 하나입니다....

NGINX Gateway Fabric Data plane 설정 이 문서는 NGINX Gateway Fabric Data plane 설정을 동적으로 업데이트 하는 방법에 관해 설명합니다. 목차 1. NGINX Gateway Fabric Data plane 개요2. 설정 조회 및 업데이트3. 수동으로 설정 생성4. NGINX Gateway Fabric D...

Jenkins – Kubernetes 클러스터 배포 가이드 이 포스트는 오픈 소스 CI(Continuous Integration / 지속적인 통합) 도구인 Jenkins 에 대해 알아보고, Jenkins를 Kubernetes 클러스터에 Helm 차트를 활용하여 배포하는 방법에 관해 설명합니다. 목차 1. Jenkins란? 1-1. ...

Istio 를 통한 JWT Claim 기반 라우팅 구현 Istio 와 같은 Service Mesh를 활용하면 JWT Claim을 손쉽게 검증하고 이를 기반으로 동적 라우팅을 구현할 수 있습니다. JWT Claim 기반 라우팅은 사용자의 정보와 권한을 바탕으로 요청을 세분화하고, 맞춤형 트래픽 분배를 가능하게 하는 효과적인 방법입니다. 해당 포스트에서는...

GitHub Action 을 통해 NGINX 로드 밸런서 배포 자동화 구현 이 블로그 포스트는 GitHub Action을 사용하여 NGINX 로드 밸런서 설정의 자동화된 배포 프로세스를 구현하는 방법을 설명합니다. GitHub Action을 활용하여 코드 변경 시 로드 밸런서 설정이 자동으로 업데이트 되도록 구성하고, 이를 통해 효율적이고 안정적인 배...

Rook Ceph 클러스터 Kubernetes 배포 가이드 이 포스트는 Kubernetes 클러스터에 Rook Ceph 클러스터를 배포하여 워커 노드의 스토리지를 통해 Ceph의 분산 스토리지 시스템을 구성하는 방법을 설명합니다. Rook은 Ceph를 Kubernetes에서 네이티브하게 실행할 수 있도록 지원하며, 이를 통해 블록, 파일, 오브젝트 스...

k8s – Multi Master Node 구성 (고가용성) Kubernetes 클러스터는 단일 마스터 노드로 운영될 경우 장애 발생 시 클러스터 전체가 정상적으로 동작하지 않을 위험이 있습니다. 이를 방지하기 위해 Multi Master Node 구성을 활용하면 클러스터의 안정성과 가용성을 향상시킬 수 있습니다. 본 문서에서는 Multi ...

K9s – Kubernetes Cluster Manager K9s 는 Kubernetes 클러스터 관리의 효율성을 극대화하기 위해 설계된 강력한 CLI 도구입니다. YAML 파일을 작성하거나 복잡한 kubectl 명령어를 기억하지 않고도 직관적인 Terminal UI에서 Kubernetes 리소스를 손쉽게 관리하고 모니터링할 수 있습니다. ...

클라우드 스토리지 유형과 특징, 활용 방안 이 포스트는 클라우드에서 주로 제공하는 세 가지 주요 스토리지 유형인 오브젝트 스토리지, 파일 스토리지, 블록 스토리지의 특징과, 각각의 스토리지를 어떤 상황에서 활용하는 것이 적합한지 설명합니다. 이러한 스토리지는 클라우드뿐만 아니라 온프레미스 환경에서도 활용할 수 있으며, 요구사항에 따라 적절한 방식으로 ...

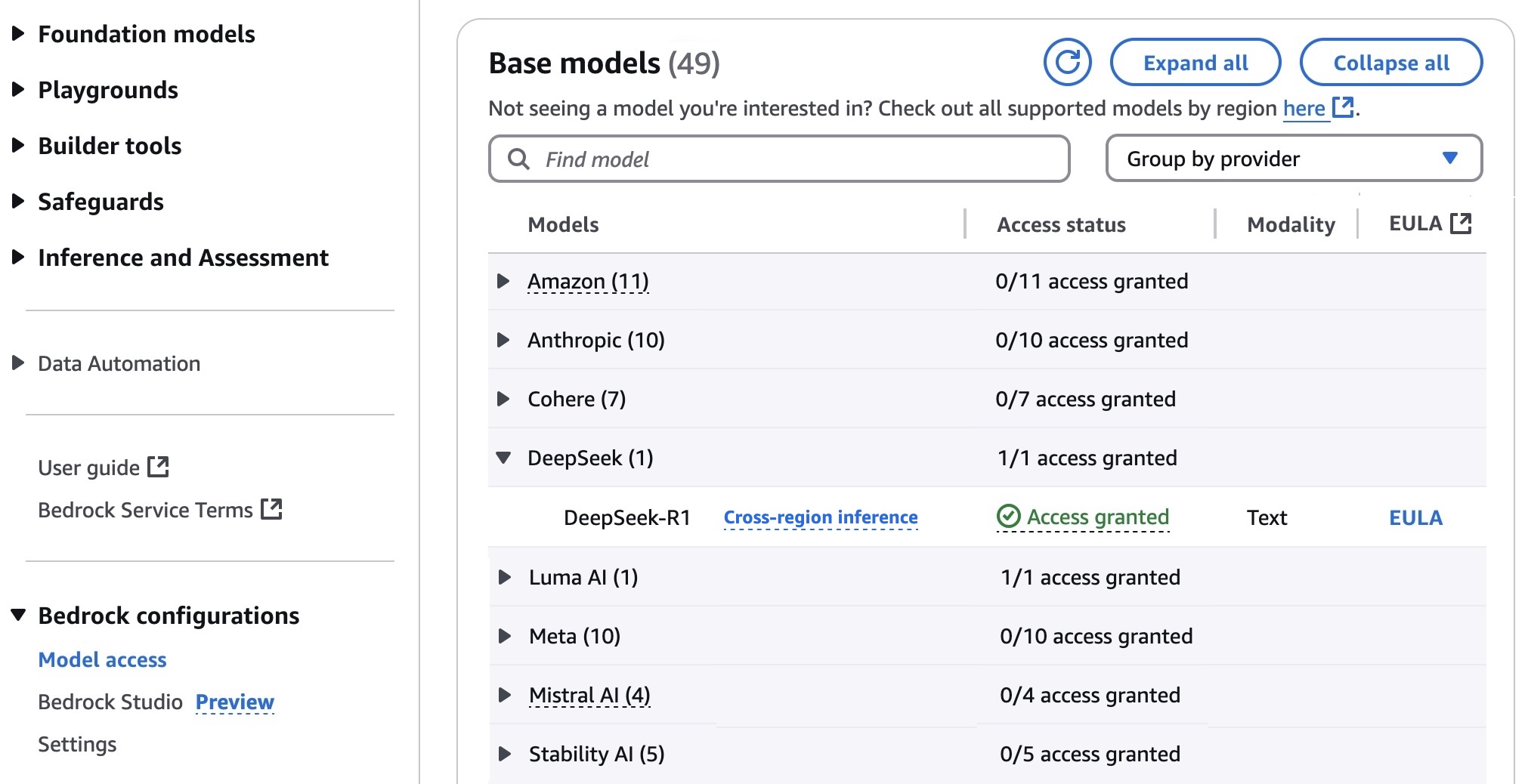

1월 30일부터 Amazon Bedrock Marketplace와 Amazon Bedrock 사용자 지정 모델 가져오기를 통해 DeepSeek-R1 모델을 Amazon Bedrock에서 사용할 수 있게 되었습니다. 그 이후로 수천 명의 고객이 Amazon Bedrock에 이 모델을 배포했습니다. 고객들은 안전한 AI 배포를 위한 견고한 가드레일과 포괄...

북반구의 날씨가 점차 따뜻해짐에 따라, 학습 및 교류의 기회가 더욱 많아지고 있습니다. 이번 주에 샌프란시스코에 머물 예정이며, AWS GenAI Loft에서 열리는 Nova Networking Night에서 만나 라이브 데모와 실제 구현을 통해 Amazon Nova 파운데이션 모델(FM)의 세계를 자세히 살펴보겠습니다. AWS Pi Day는 이제 연...

![[CSAP 성공 사례집 #1] 디딤365가 푸는 검증된 전문가의 클라우드 보안 인증 공략법](https://blogthumb.pstatic.net/MjAyNTAzMDZfMTc0/MDAxNzQxMjI2MDcyODg0.ejtJ1Y_ZcZjmzw36jHPGrhlWAq6IdPLi9vK0w7mB1pIg.nUHX6FO_KhBtrdoeTdv02p76MW0uezIf4ou0GKHoUQMg.PNG/250305_%B0%F8%B0%F8%BB%E7%BD%BA%B0%ED%B0%B4%BB%E7%B7%CA1.png?type=s3)

안녕하세요. 누구나 쉽게 시작하는 클라우드 네이버클라우드 ncloud.com 입니다. 이번 포스팅에서는 네이버 클라우드 플랫폼을 활용해 공공시장 진출 시 필수인 CSAP 보안인증 요건을 해결하는 '디딤365'를 소개해 드리려고 해요! 디딤365는 네이버클라우드의 파트너사로, 공공기관과 비즈니스를 위한 디지털 전환을 지원하고, 컨설팅하고 있습니다. 디딤...

Istio Traffic Management: 모범 사례 살펴보기 이 블로그 포스트는 Istio 를 사용하며 네트워킹 또는 트래픽 관리 문제를 방지하기 위한 특정 배포 또는 구성 지침을 제공합니다. 목차 1. 서비스의 기본 경로 설정2. 네임스페이스 간 구성 공유 제어3. 네임스페이스 간 Istio Destination Rule 적용 문제4. Isti...

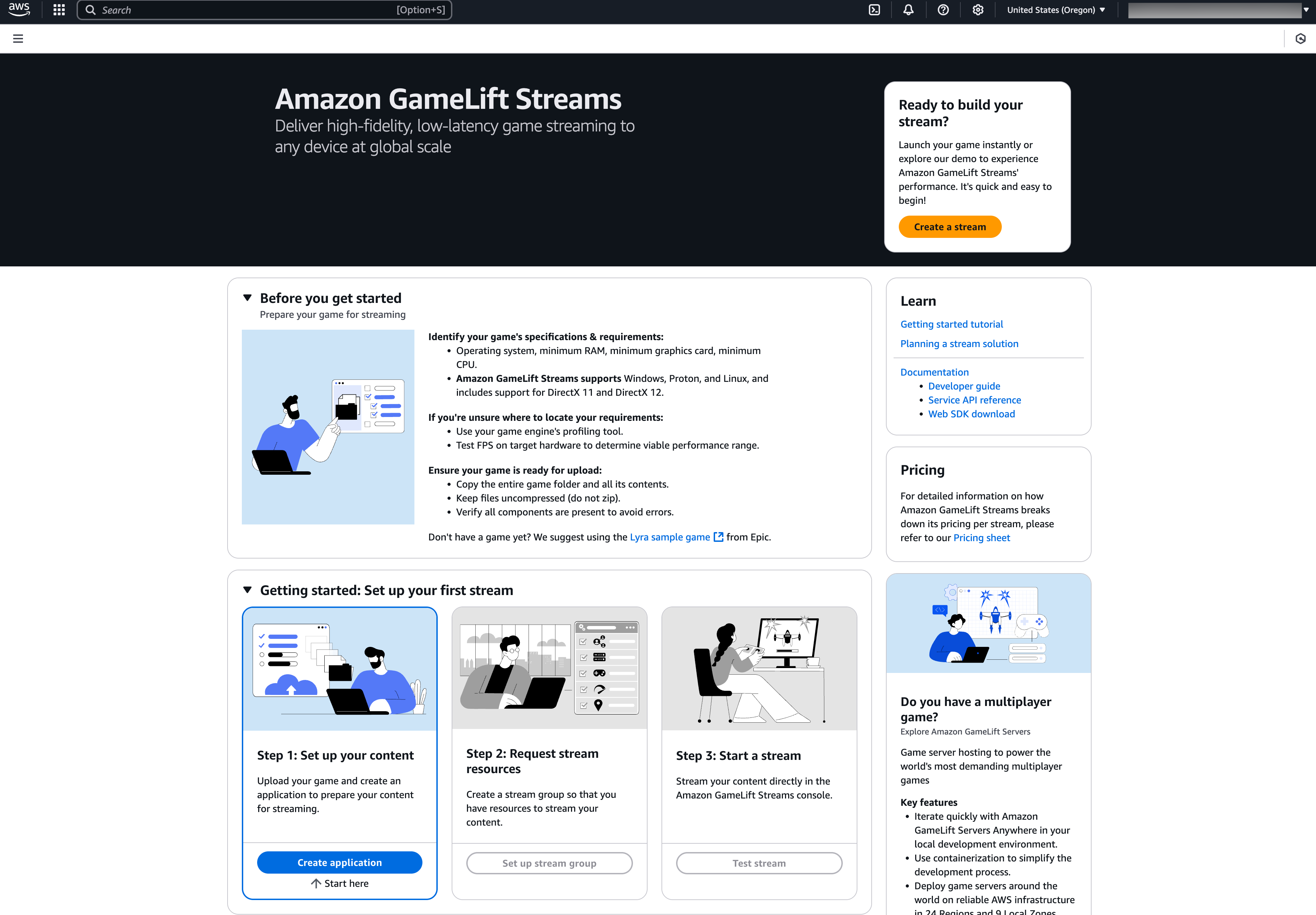

2016년부터 게임 개발자들은 단일 게임에서 1억 명의 동시 사용자(CCU)를 지원할 수 있는 확장 가능한 전용 서버 호스팅을 통해 게임을 지원하는 Amazon GameLift를 사용해 왔습니다. 게임 서버 이외의 추가 관리형 컴퓨팅 기능에 대한 고객 요청에 부응하여 게임 퍼블리셔가 글로벌 플레이어와 직접 연결되는 게임 스트리밍 경험을 구축하고 제공할...

![[모집] 6년 연속 최대 9,600만 원 지원 중! 핀테크 기업을 위한 금융 클라우드 지원 사업 (~4/4)](https://blogthumb.pstatic.net/MjAyNTAzMDdfMTQ1/MDAxNzQxMzEzMjEzOTcx.LwwaoGmGlUShKUdZK5AHnCC3OSYlP-iT7W8WG1mATiAg.QcAexnPkFqi_gvUViAZ3dotGkch33Urtr9dXe4N3S1Ig.PNG/Blog_240306.png?type=s3)

안녕하세요, 누구나 쉽게 시작하는 클라우드 네이버클라우드 ncloud.com입니다. 돈과 개인정보를 다루는 만큼 금융∙핀테크 업계는 보안이 정말 중요한데요. 그렇기 때문에 금융∙핀테크 기업이 혁신적인 서비스를 개발하기 위해선 믿을 수 있는 안전한 클라우드 환경이 꼭 필요합니다. 하지만 중소 핀테크 기업이 보안 요건이 충족된 클라우드 인프라를 구축하는 ...